[Bibliométrie] Einstein vaut-il la moitié du Dr Raoult ? Pour en finir avec « l’indice h »

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.

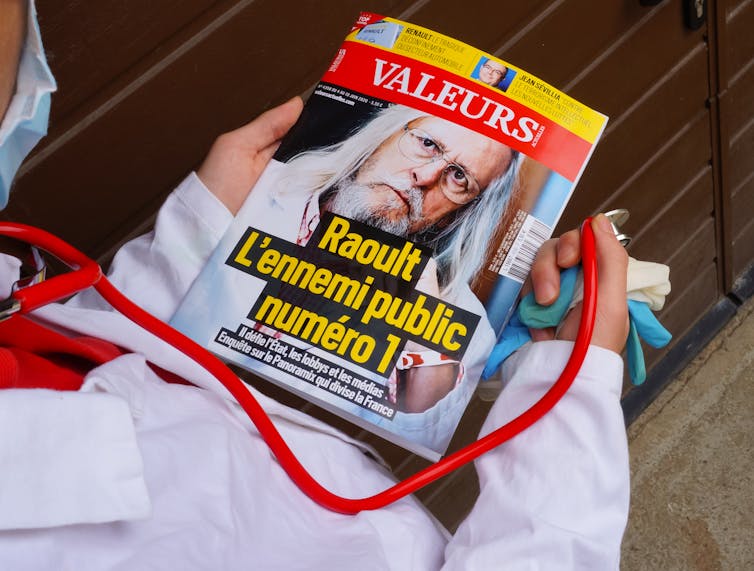

La controverse médiatique entourant le professeur Didier Raoult fournit l’occasion de revenir sur l’omniprésent indice bibliométrique « h-index », inventé en 2005 par le physicien américain John Hirsch (d’où le choix de la lettre « h » pour désigner cet indice).

L’« indice h », ou « facteur h », en français est devenu en l’espace de quelques années une référence incontournable chez de nombreux chercheurs et gestionnaires du monde académique.

Il est particulièrement promu et utilisé en sciences biomédicales, domaine où la massification des publications semble avoir rendu impossible toute évaluation qualitative sérieuse des travaux des chercheurs. Cet « indicateur » est devenu le « miroir aux alouettes de l’évaluation », devant lequel les chercheurs s’admirent ou ricanent en constatant le piteux « indice h » de leurs « chers collègues », mais néanmoins rivaux.

Bien que les experts en bibliométrie aient rapidement noté le caractère douteux de cet indicateur composite, la plupart des chercheurs ne semblent pas toujours comprendre que ses propriétés sont loin d’en faire un indice valide pour évaluer sérieusement et éthiquement leur « qualité » ou leur « impact » scientifique.

Le plus souvent, ses promoteurs commettent d’ailleurs une erreur de logique élémentaire en affirmant que les lauréats de prix Nobel ont « en général » un indice h élevé, preuve qu’il mesure bien la qualité individuelle des chercheurs. Or, si un indice h élevé peut en effet être associé à un Nobel, cela ne prouve nullement qu’un indice h peu élevé soit nécessairement associé à un « piètre » chercheur. En effet, un indice h en apparence faible peut cacher un impact scientifique élevé, du moins si l’on accepte que l’unité de mesure habituelle de cette visibilité scientifique se reflète dans le nombre de citations reçues.

Les limites de l’indice h

Défini comme le nombre d’articles N d’un auteur ayant chacun reçu au moins N citations, on voit immédiatement que cet indice est borné par le nombre total d’articles. En d’autres termes, si une personne a vingt articles cités cent fois chacun, son indice h est de 20, tout comme une personne qui a aussi vingt articles, mais cités chacun seulement vingt fois, soit cinq fois moins ! Mais quel chercheur sérieux dirait que les deux sont « égaux » du fait que leur indice h est le même ? Or, si un indicateur n’est pas proportionnel au concept qu’il est censé mesurer, alors il est invalide.

Le plus ironique dans l’histoire de l’indice h est que son inventeur voulait au départ contrer l’usage du nombre de papiers, qui selon lui ne représentait pas bien l’impact scientifique d’un chercheur. Il pensait donc le « corriger » en le combinant au nombre de citations que les articles reçoivent. Pis, il s’avère que l’indice h est en fait très fortement corrélé (à hauteur d’environ 0.9) avec le nombre de publications ! En d’autres mots, c’est bel et bien le nombre de publications qui fait grimper l’indice h davantage que le nombre de citations, indicateur qui, malgré ses limites, demeure la meilleure mesure de l’impact des publications scientifiques.

Tout cela est connu des experts, mais peut-être pas des chercheurs, des évaluateurs et des journalistes qui se laissent impressionner par les personnages se pavanant avec leur indice h collé au front.

Raoult vs Einstein

Dans une récente enquête de Médiapart, une chercheure faisant partie du comité d’évaluation du laboratoire du Dr Raoult, avait confié au journaliste ne pas s’être laissée impressionner : « Ce qui m’a marqué, raconte-t-elle, c’est l’obsession de Didier Raoult pour ses publications. Quelques minutes avant que ne commence l’évaluation de son unité, c’est d’ailleurs la première chose qu’il m’a montrée sur son ordinateur, son facteur h. »

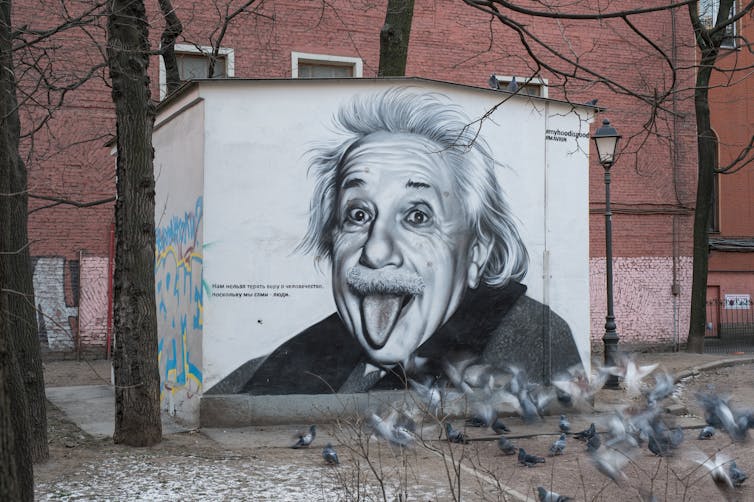

Le Dr Raoult avait lui-même affirmé en 2015 dans le magazine Le Point qu’il fallait « compter le nombre et l’impact des publications des chercheurs pour évaluer la qualité de leur travail ». Examinons donc le fameux « facteur h » du Dr Raoult et regardons comment il se compare, disons, avec celui d’un chercheur qui est communément considéré comme le plus grand savant du dernier siècle : Albert Einstein.

Dans la base de données Web of Science (WoS), Didier Raoult compte 2053 articles publiés entre 1979 et 2018, ayant reçu un total de 72 847 citations. Son indice h calculé à partir de ces deux données est de 120. On sait cependant que la valeur de l’indice h peut être gonflée artificiellement grâce aux citations faites par un auteur à ses propres articles, ce que l’on appelle des autocitations. Or, le WoS indique que parmi les citations totales attribuées aux articles co-signés par Didier Raoult, 18 145 proviennent d’articles dont il est légalement cosignataire, ce qui équivaut à un taux d’autocitations de 25 %. En ignorant ces autocitations, l’indice h de Raoult baisse de 13 % à une valeur de 104.

Intéressons-nous maintenant au cas d’Albert Einstein. Ce dernier compte 147 articles recensés par le WoS entre 1901 et 1955, année de son décès, pour un total de 1564 citations reçues de son vivant. Sur ces 1564 citations, seules 27, soit un maigre 1,7 %, sont des autocitations. Si l’on rajoute les citations faites à ses articles après son décès, Einstein a reçu un total de 28 404 citations entre 1901 et 2019. À partir de ces données de publications et de citations, Einstein obtient un indice h de 56.

Si l’on doit se fier à la mesure dite « objective » de l’indice h, on est alors forcé de conclure que les travaux de Didier Raoult, avec son indice corrigé de 104, ont un impact et une portée scientifiques deux fois plus importants que ceux du père du photon, des relativités restreinte et générale, de la condensation Bose-Einstein et du phénomène de l’émission stimulée à l’origine des lasers. Peut-être vaudrait-il mieux en conclure, comme suggéré plus haut, que l’indicateur est tout simplement bidon ?

Notons également la différence importante du nombre de citations totales reçues par chacun des chercheurs au cours de leur carrière. Ils ont évidemment été actifs à des périodes très différentes, la taille des communautés scientifiques, et donc le nombre de potentiels auteurs citant, s’étant considérablement accru au cours du dernier demi-siècle. Il faut aussi tenir compte des différences disciplinaires et des pratiques de collaboration. Par exemple, la physique théorique compte beaucoup moins de contributeurs que la microbiologie, de même que le nombre de co-auteurs par article y est plus petit, ce qui influe sur la « productivité » et la mesure de l’impact des chercheurs et rend l’usage comparatif de l’indice h plus que problématique.

Enfin, il est important de noter que l’énoncé : « L’indice h de la personne P est de X », n’a en fait aucune signification, car la valeur de l’indice dépend du contenu de la base de données utilisée. Il faut plutôt dire « L’indice h de la personne P est de X, dans la base de données Z ». Ainsi, selon la base de données WoS, qui ne contient que des revues considérées comme sérieuses et assez visibles dans le champ scientifique, l’indice h de Didier Raoult est de 120. Par contre dans la base de données gratuite et donc facilement accessible de Google Scholar, qui contient toutes sortes de documents hétérogènes, y compris des documents « pdf » déposés sur divers sites Internet, ce même indice h — repris par la plupart des médias — monte à 179.

Le fétichisme d’un chiffre

La communauté scientifique voue un véritable culte à l’indice h. Et ce fétichisme pour un simple chiffre peut avoir des conséquences néfastes pour la recherche scientifique. La France, par exemple, utilise le Système d’interrogation, de gestion et d’analyse des publications scientifiques (SIGAPS) pour octroyer des fonds de recherches à ses laboratoires de sciences biomédicales, sur la base du nombre d’articles qu’ils publient dans les revues dites « à fort facteur d’impact ». Comme le rapporte Le Parisien, le rythme frénétique de publications du Dr Raoult permet à son institution de rattachement d’engranger entre 3 600 et 14 400 euros par an, pour chaque article publié par son équipe.

L’aveuglement engendré par les dérives de l’évaluation de la recherche est intéressant et réclamerait des études sur la psychologie des chercheurs. Le biologiste Bruno Lemaître, a publié un livre éclairant sur le narcissisme des chercheurs. Il faudrait peut-être compléter cette étude par une analyse du syndrome du cerveau scindé, résultant de la déconnexion entre les deux hémisphères cérébraux : capables de déceler des erreurs mineures dans les publications de leurs collègues, de nombreux chercheurs semblent démunis lorsque confrontés aux déformations créées par leur « miroir aux alouettes de l’évaluation ».

Les bons usages de la bibliométrie, voire même le simple bon sens, devraient nous apprendre à nous méfier des indicateurs simplistes et unidimensionnels. Ralentir le rythme affolant des publications scientifiques — souvent d’utilité limitée en dehors du remplissage des CV académiques — conduirait certainement les chercheurs à se désintéresser de l’indice h. Plus important, il contribuerait à produire des connaissances certes moins nombreuses, mais assurément plus robustes.![]()

Yves Gingras, Professeur, Université du Québec à Montréal (UQAM) et Mahdi Khelfaoui, Professeur associé, Université du Québec à Montréal (UQAM)

À lire aussi sur The Conversation France :

Être juge et partie, ou comment contrôler une revue scientifique