La migration du data center : un vrai défi !

Point sur le projet

Aujourd’hui les moyens informatiques (calcul, stockage, réseau, sauvegarde) de l’Université de Lorraine, de la métropole du Grand Nancy, du CHRU de Nancy et de la Délégation du CNRS Grand-Est se trouvent sur plusieurs sites distincts.

L’explosion de la production de données, les coûts d’exploitation afférents, la contrainte de renforcer la sécurité face aux menaces récurrentes, les nouveaux enjeux énergétiques, ont incité les directions informatiques à mutualiser leurs ressources pour répondre aux nouveaux usages du 21 siècle. C’est pourquoi l’idée de créer un data center mutualisé a émergé il y a plusieurs années.

Ce projet nécessite de nouveaux locaux pour héberger les futures infrastructures informatiques. Il sera implanté dans le bâtiment Apollo sur le campus Jean Zay et s’appellera le data center mutualisé lorrain (DCML). Comme vous l’avez constaté les travaux ont démarré avec la réfection de la toiture du bâtiment. La livraison de cette nouvelle infrastructure est prévue en fin d’année 2022.

Ce nouveau data center accueillera également les moyens de calculs intensifs de l’UL (Mésocentre Explor) et du Loria (Grid5000).

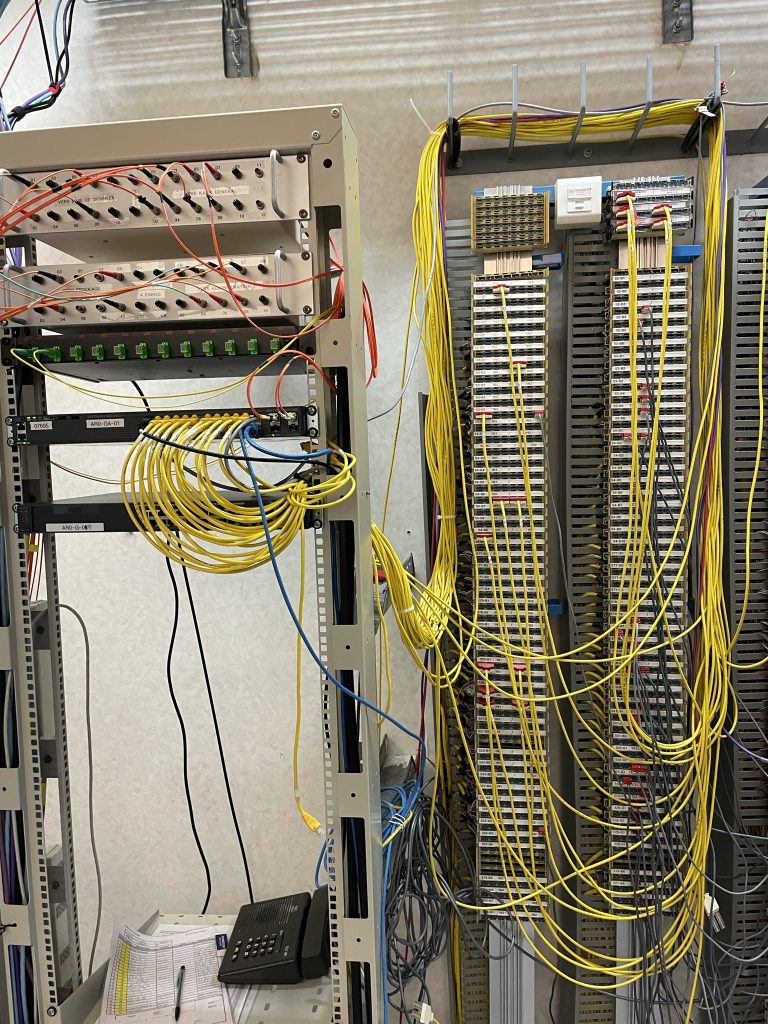

Historiquement l’INIST – CNRS possède son propre centre de données dont la technologie, 33 ans plus tard, est devenue obsolète et énergivore. Il était donc logique qu’UAR76 intègre le DCML.

Le service ISI anticipe déjà les modifications à apporter à l’architecture réseau actuelle pour faciliter le futur déménagement.

|

|

|

|

|

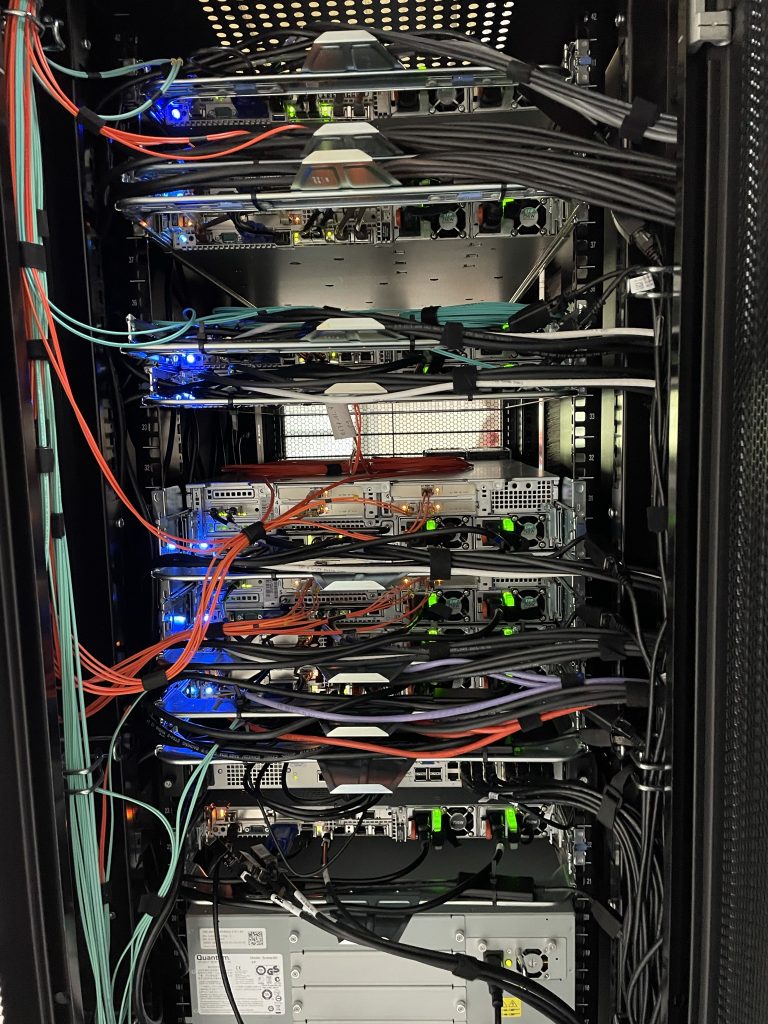

Datacenter de l’Inist, Septembre 2021 |

|

Un bel espace dédié au CNRS Saut technologique et performance

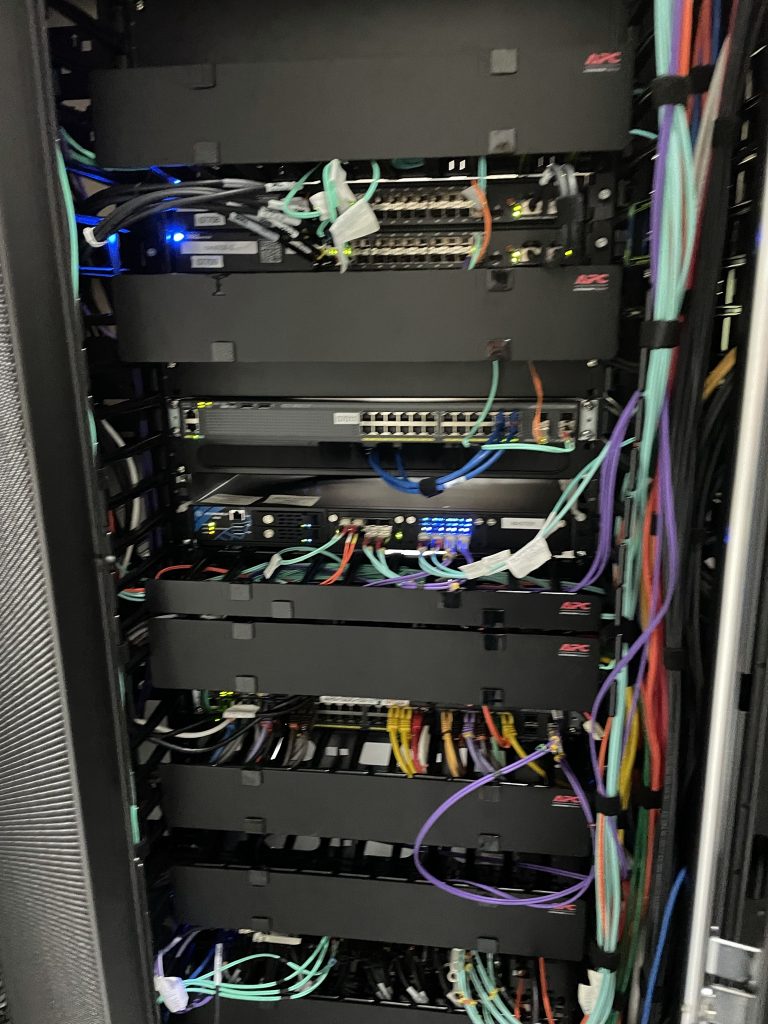

Les racks (Baie en Français) sont les armoires d’une hauteur de 47 U (pouce) qui contiennent les équipements informatiques (serveurs, baies de stockage, commutateurs réseau…) qui constituent le data center.

Le DCML sera divisé en 8 espaces distincts. Le CNRS bénéficiera de 10 racks répartis sur 2 salles. Pour contextualiser, actuellement les données de la délégation nécessitent 1 rack et les besoins de l’Inist un peu moins de 4 rack (1 rack= 47 unité de stockage, besoin de l’Inist : 150 unités de stockage). Le CNRS bénéficiera donc d’un bel espace dédié.

Construit il y a environ 30 ans, la technologie de refroidissement du data center de l’Inist n’est plus optimale et de plus énergivore. Il s’agit d’un système qui refroidi toute la salle du DC. Aujourd’hui la technologie (système de cloche) tend à ne refroidir que le matériel informatique pour éviter la déperdition d’énergie.

Dans le nouveau data center les racks aspireront l’air froid sur leurs faces avant et rejetteront l’air chaud sur leurs faces arrières. Cette mise en place appelée « couloirs chauds, couloirs froids » améliore le contrôle des flux d’air. Ce qui est bien plus efficace que de refroidir une salle entière.

On obtient un meilleur contrôle des systèmes de refroidissement et cela permet de réduire les coûts énergétiques et financiers.

De nouvelles fonctionnalités

La nouvelle configuration permettra le pilotage à distance des équipements. Pour les non-initiés, les différents services auront leurs propres réseaux, et en cas de problème les services informatiques pourront agir à distance.

Cette fonctionnalité s’appelle l’administration hors bande (Out-of-band management) et permet un accès 24h/24 aux routeurs, aux commutateurs, au pare-feu, aux serveurs, aux appareils d’alimentation, de stockage et de télécommunication… Avant l’accès à ces ressources informatiques critiques se faisaient sur le même réseau que les données.

Des investissements pour augmenter les performances

Le défi du service ingénierie des systèmes d’informations

« La relocalisation d’un data center ne s’improvise pas ! » explique Angel Turri, responsable du service ingénierie des systèmes d’informations. Il ne suffit pas de débrancher les équipements informatiques actuels et les rebrancher dans le nouveau data center. C’est un véritable challenge qui nécessite en prérequis la modification de notre configuration réseau actuelle.

La modification du réseau

L’actuelle organisation du réseau bâtiments utilisateurs n’est pas compatible avec le nouveau data center.

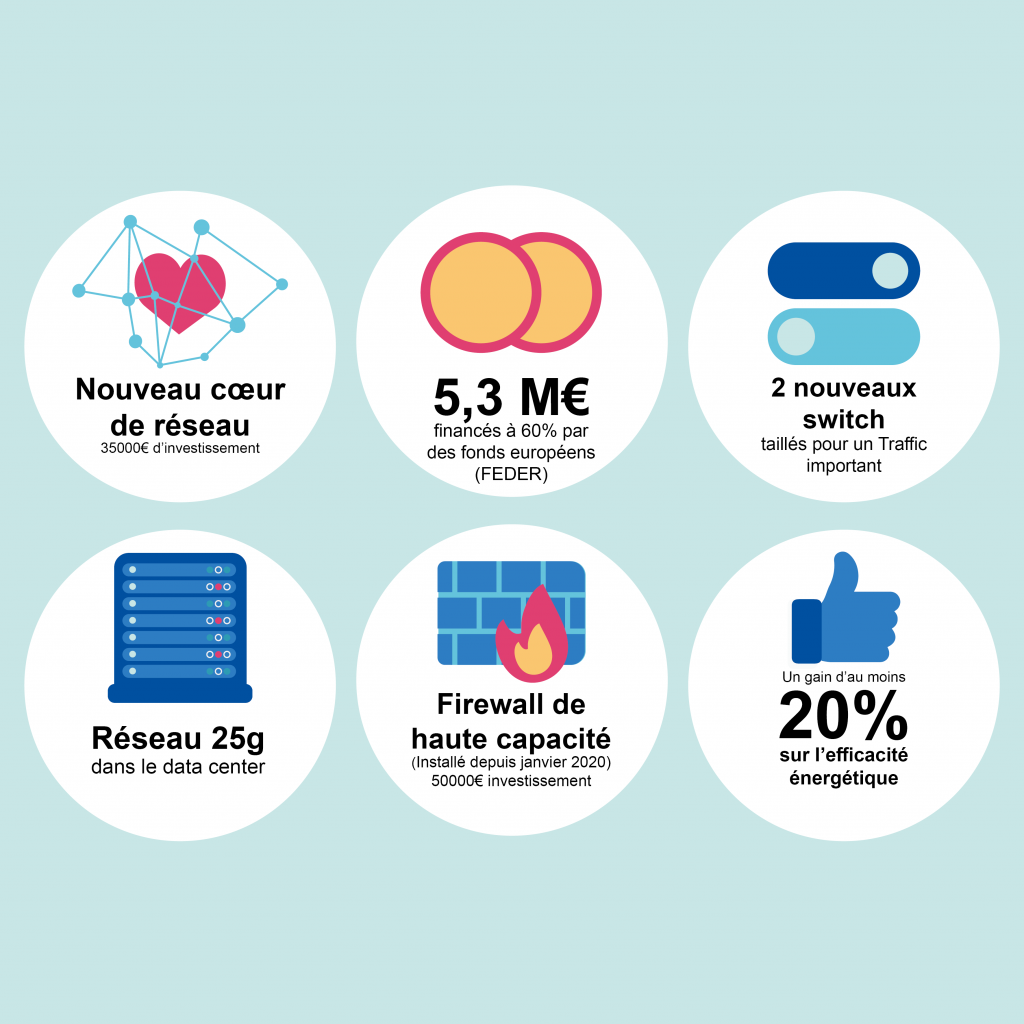

Des investissements ont été anticipés et étalés depuis fin 2019 : remplacement du pare-feu (point d’entrée du réseau) par une solution à haute capacité, acquisition d’un nouveau cœur de réseau à 100Gb/s, acquisition de 2 commutateurs 25Gb/s. Sylvain PONTICELLI, responsable de l’architecture réseau est en charge de cette transformation et de la mise œuvre de ces nouveaux équipements.

L’objectif est de terminer cette première phase d’ici fin 2021.

Le déménagement

2022 sera consacré à la préparation du déménagement proprement dit.

L’objectif étant de réaliser cette migration avec un minimum de perturbations pour l’ensemble des utilisateurs du SI de l’INIST – CNRS.

On ne s’en rend pas toujours compte mais il faut savoir que les datacenters soutiennent une partie de plus en plus importante (si ce n’est l’ensemble) de l’activité des entreprises, et c’est notamment le cas à l’Inist.

Le service ingénierie des systèmes d’informations se donne donc la mission de limiter au maximum, voire d’éviter une interruption de service afin de vous permettre une continuité de service.